最近,谷歌推出的一个新文本生成图像AI模型DreamFusion ,可以直接将文本转换成3D 模型。(工具网址:dreamfusion3d.github.io)

这个AI图像模型是使用的方法是将文本到2D图像扩散的模型与神经辐射场(NeRF)相结合,生成质量适合于 AR 项目或作为雕刻的基础网格的带纹理3D模型。

根据官方介绍,最近在文本到图像合成方面的突破是由在数十亿对图像-文本训练的扩散模型推动的。不过,将这种方法应用于3D合成需要标记3D资产的大规模数据集和高效的3D数据去噪方法,这两种方法目前都不存在。在这项工作中,谷歌研究团队通过使用预训练的2D文本到图像扩散模型来执行文本到3D合成,从而绕过这些限制。

通过消除对此类大规模3D数据集的需求,DreamFusion模型不需要一组真实的3D模型来用作培训数据,也不需要修改图像扩散模型,这为开发适用于大众并且实用的AI的文本到3D工具铺平了道路。

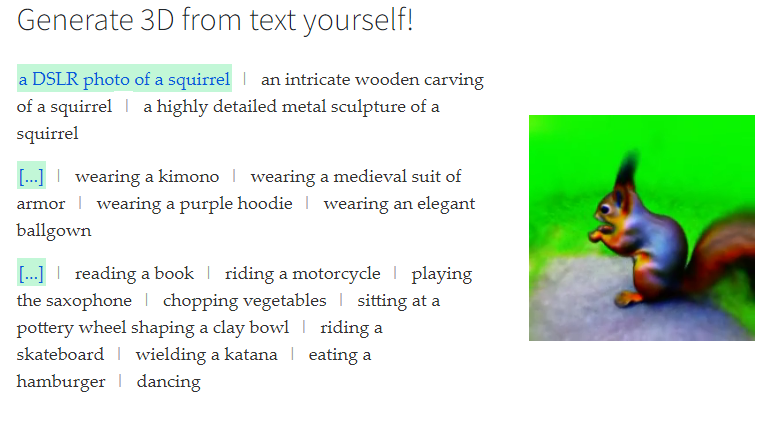

比较可惜的是,目前DreamFusion项目的GitHub页面只支持从原有预设文本提示中进行选择,然后显示生成的3D模型,不支持随意输入文本生成模型。

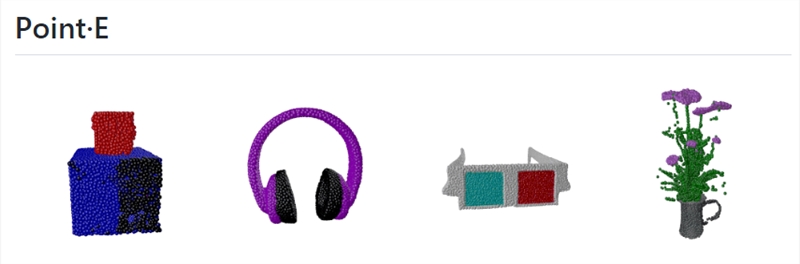

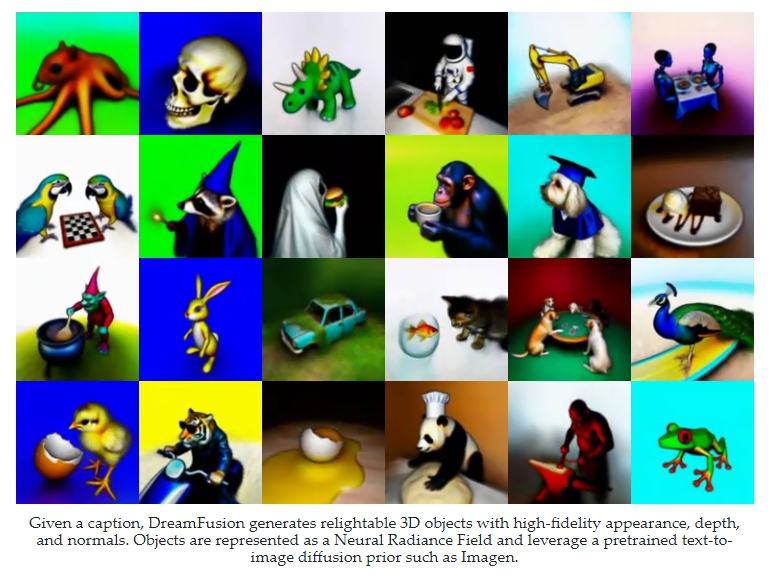

比如给出文本提示,DreamFusion 生成具有高保真外观、带纹理的3D 模型。例如输入文本“一个非常精细的松鼠金属雕塑,穿着金色衣服,正在吹萨克斯”,生成的模型效果如下:

下面一起来看看DreamFusion生成的3D模型效果:

注:本文图片均来自dreamfusion3d官网截图。